概述

之前出过yolov5、yolov8的教程,现在yolov11出来了,其实yolov11和yolov8的使用方式没区别,这里还是来提供下使用教学,这次我们就用虚拟环境方式了,不用本地环境,防止依赖混乱。

我们的目标

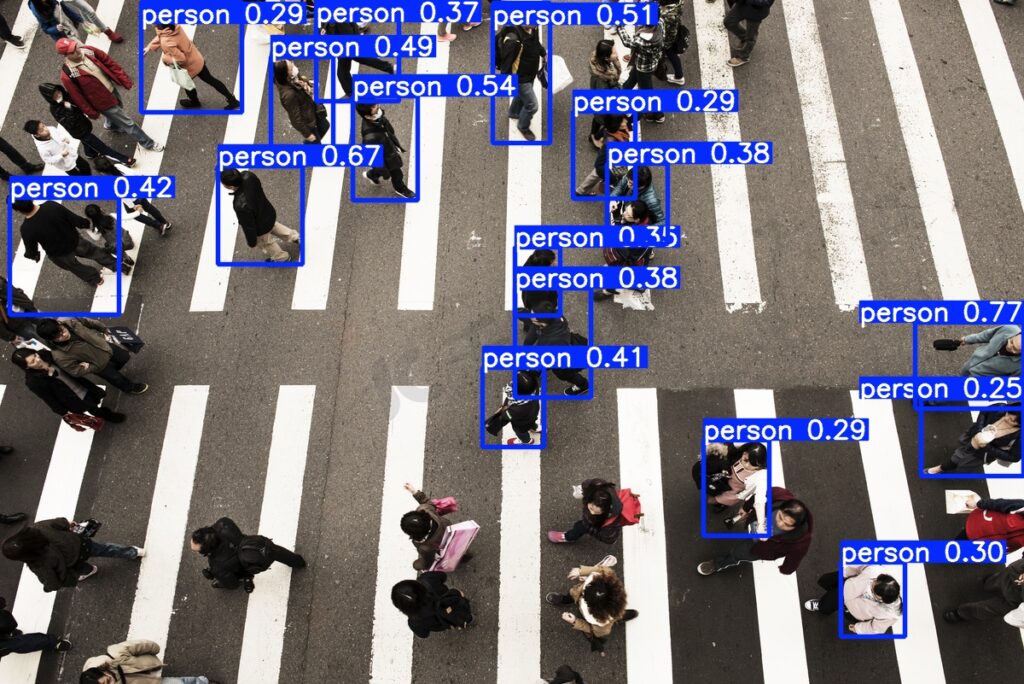

将一张行人的图进行识别并能得到识别后标注的图片以及一些相关的信息,如下

识别前:

识别后:

正文

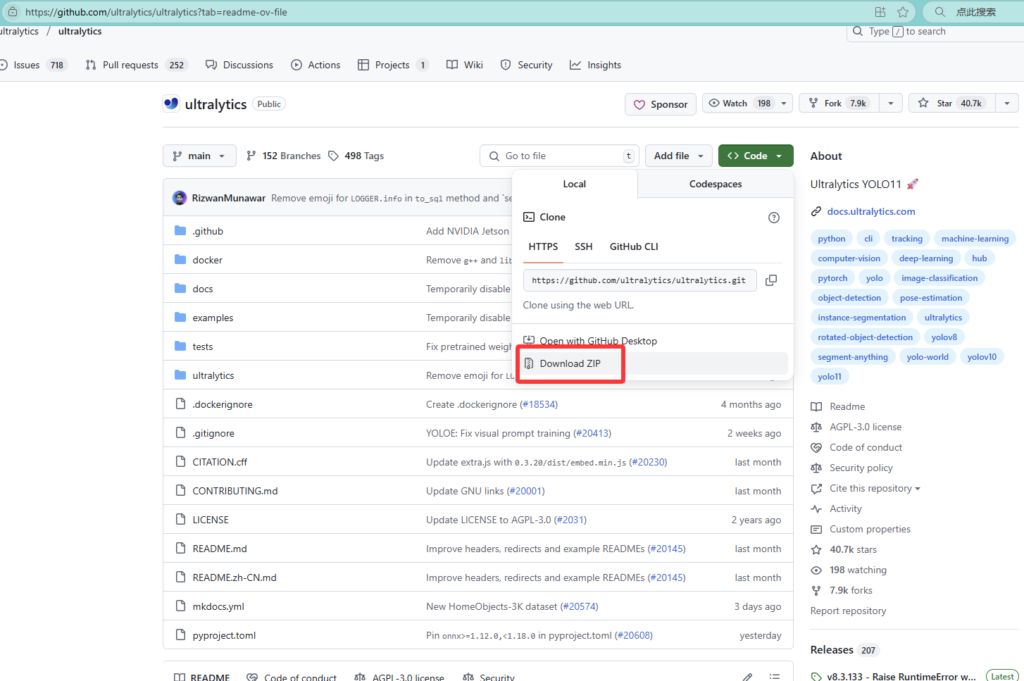

下载ultralytics源码

访问官网 ultralytics/ultralytics: Ultralytics YOLO11 🚀 ,下载源码,如图

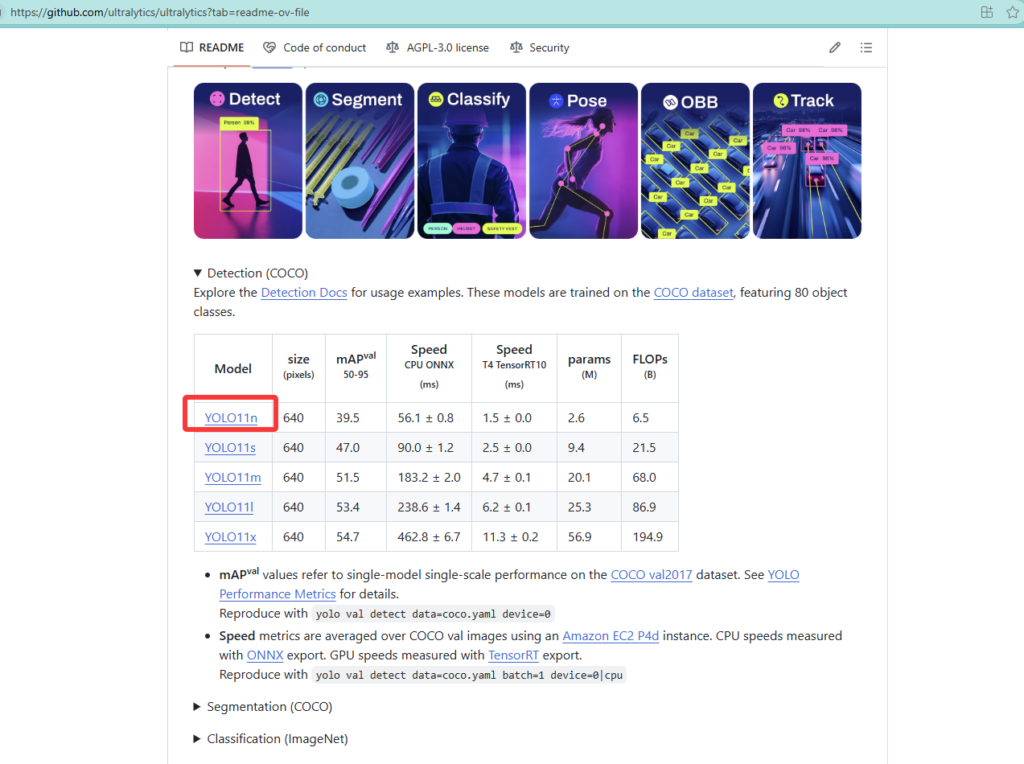

下载预训练模型

在上方官网向下翻即可看到,这里我下载的是yolo11n,体积最小,后续做测试速度快,如图

创建虚拟环境

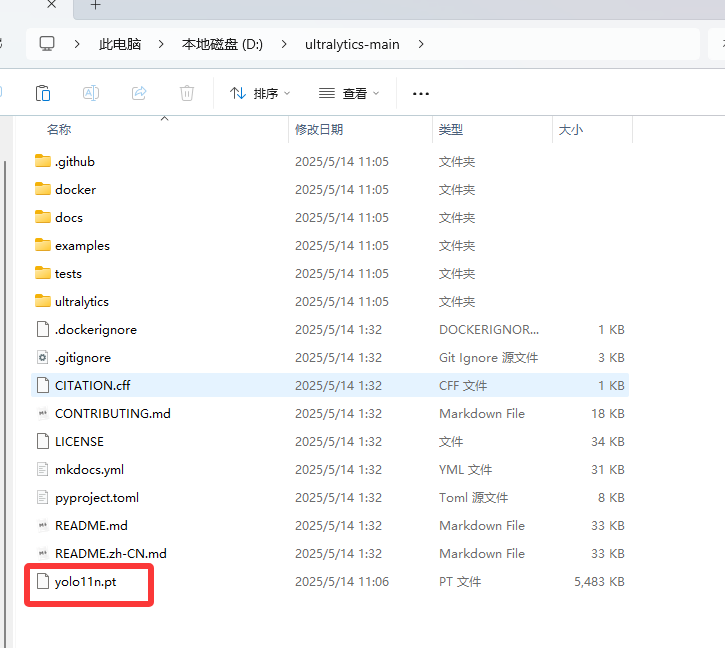

将下载的 ultralytics-main压缩包解压到一个位置,然后再将yolo11n放入其根目录,如图

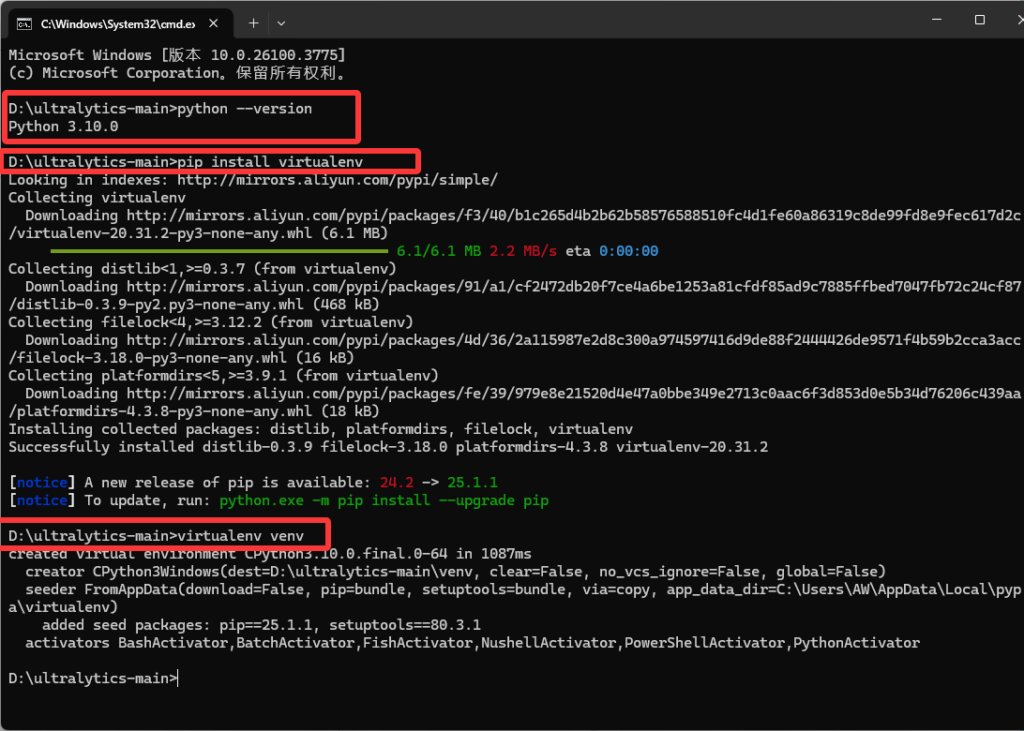

使用cmd命令进入ultralytics-main目录,这里我建议首先确定自己的python版本,执行命令

python --version下面我会提供torch显卡版三件套的离线文件,如果按照本文来的话,建议将环境替换为python3.10(非必须)

再下载虚拟环境库,执行

pip install virtualenv然后创建虚拟环境,执行命令

virtualenv venv如图

进入虚拟环境

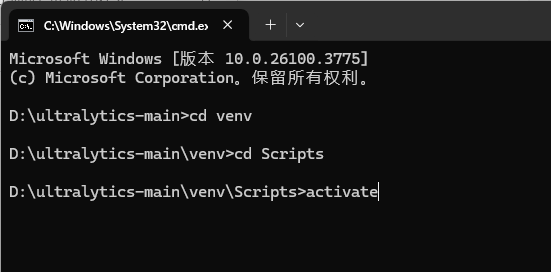

cd进入到刚才创建的venv下的Scripts目录,执行命令

cd venv

cd Scripts然后执行activate激活虚拟环境,如图

下载Ultralytics所需依赖

在下载依赖前,你需要明白,你是需要用 CPU来做识别任务、还是用GPU来做识别任务?如果你是用CPU来做的话,直接执行如下命令,因为他默认会安装cpu版本的torch环境

pip install ultralytics如果你想和我一样使用GPU的环境,请先点击以下三个离线包开始下载(这里请注意,下方三个文件中包含cp310,这表示需要你的python版本为3.10),先不要执行上面的命令

torch-2.2.1+cu121-cp310-cp310-win_amd64.whl

torchvision-0.17.1+cu121-cp310-cp310-win_amd64.whl

torchaudio-2.2.1+cu121-cp310-cp310-win_amd64.whl

然后,将这三个离线包放到venv的Scripts目录下,如图

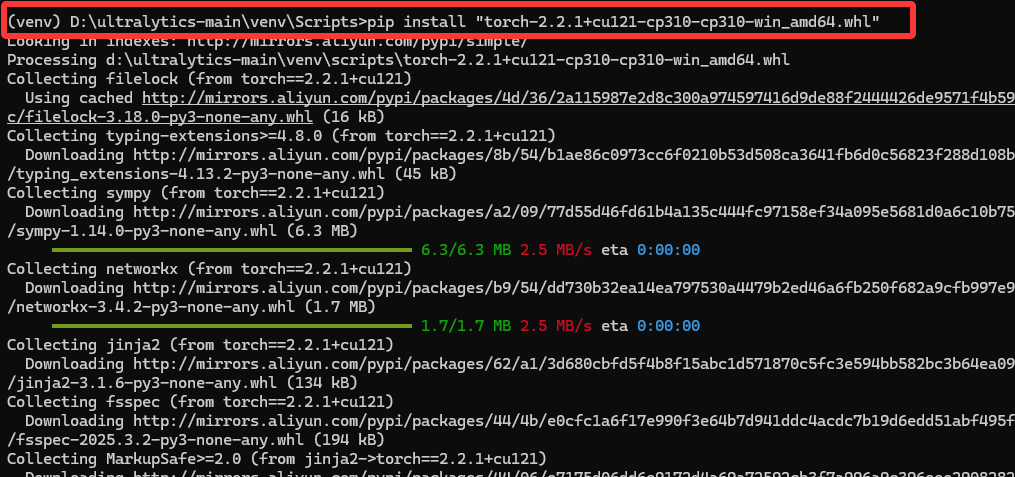

还是在Scripts目录的终端下,执行如下三条命令以安装GPU版的torch,

pip install "torch-2.2.1+cu121-cp310-cp310-win_amd64.whl"

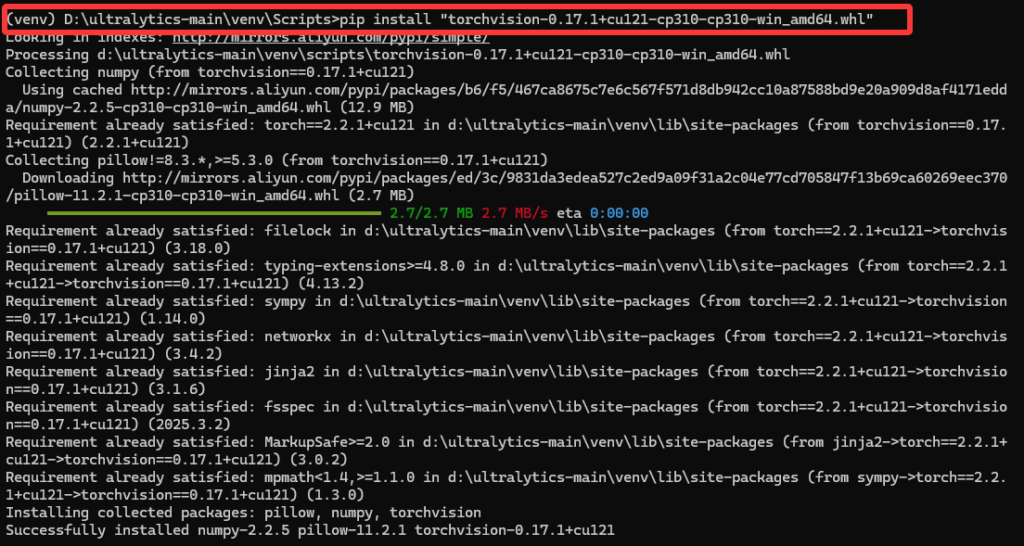

pip install "torchvision-0.17.1+cu121-cp310-cp310-win_amd64.whl"

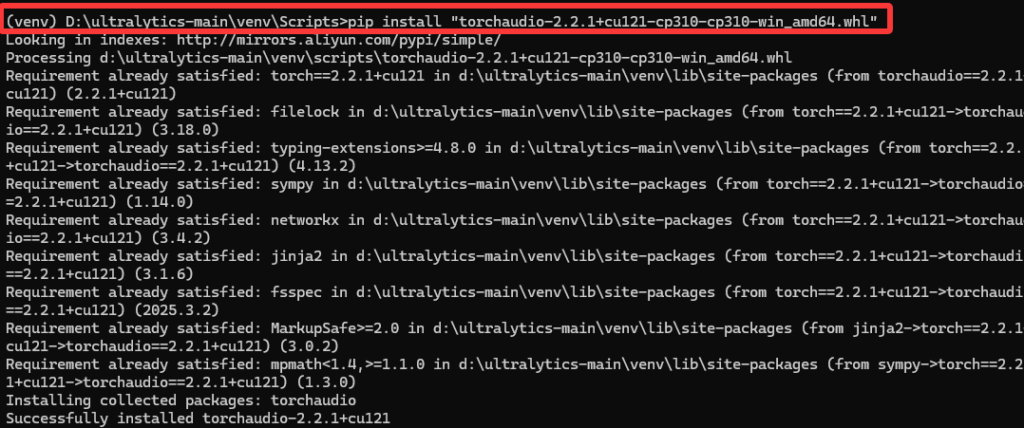

pip install "torchaudio-2.2.1+cu121-cp310-cp310-win_amd64.whl"如图

安装torch

安装torchvision

安装torchaudio

最后我们再执行如下命令安装ultralytics所需库,上面安装了GPU版本的torch,这里就会自动跳过安装cpu版本的torch

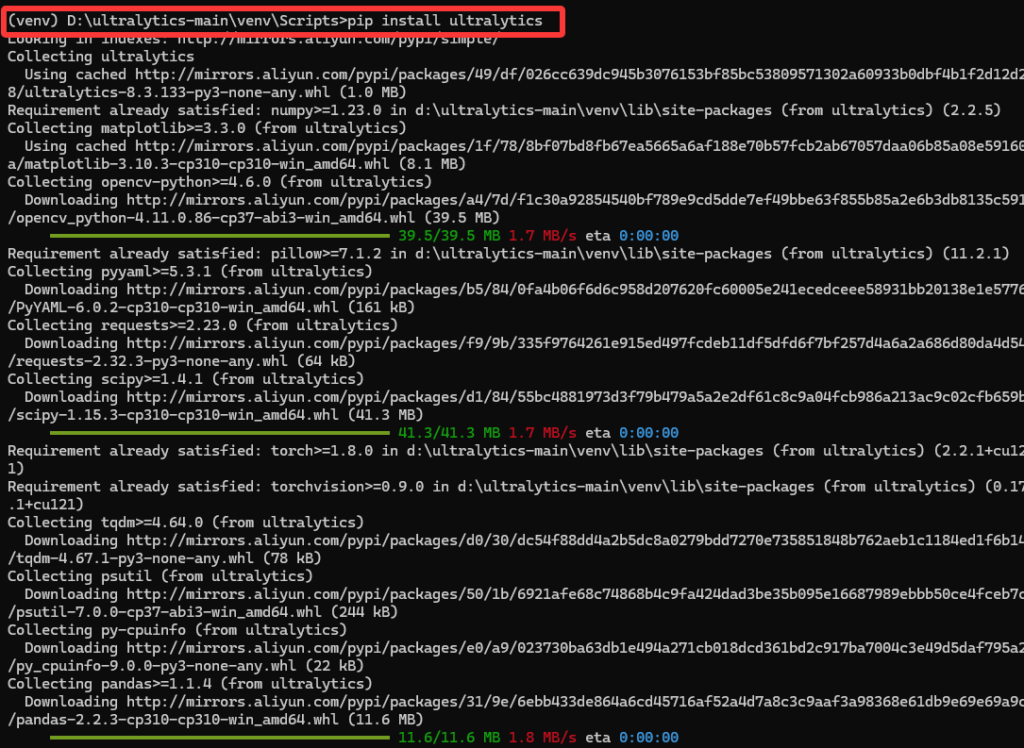

pip install ultralytics如图

准备测试识别

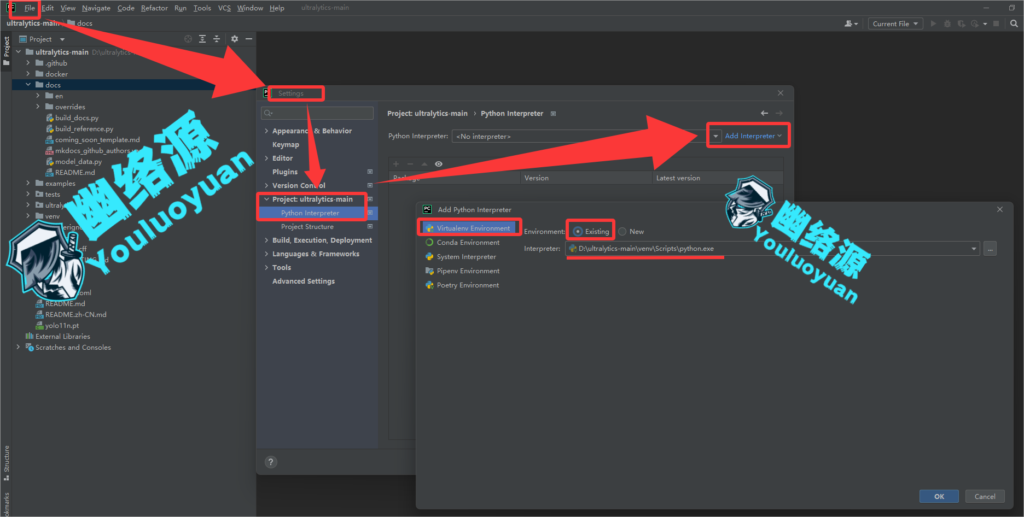

这里用pycharm打开ultralytics-main项目,然后为其配置虚拟环境的解释器,如图

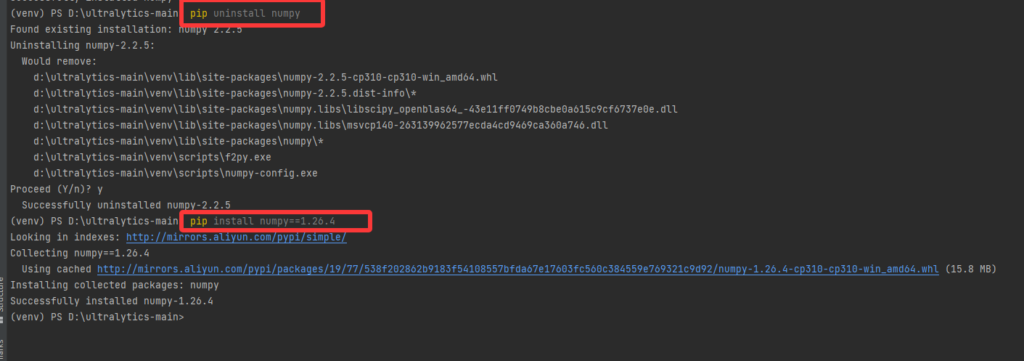

这里还需要将numpy版本降低,默认下载的numpy版本为2.2.5,但是与我们项目不兼容,这里建议更换为1.26.4,按照如图重装numpy指定版本

在项目下,我们新建一个python文件名为”识别测试.py”,加入如下代码

from ultralytics import YOLO

yolo11=YOLO(model=r"yolo11n.pt",task="detect") #加载模型

result=yolo11(source=r"xr.jpg", save=True)

print(result)然后随便找一张带有 人、狗、猫、车 其中之一的这些的图片,将其放在根目录,命名为xr.jpg,再运行我们的”识别测试.py”,结果如图

也就是运行我们的识别测试代码后,项目根目录下会多出一个runs目录,里面便是识别后的标注的图片,且通过控制台可以看到,我们代码中输出的结果中其实包含了识别后大量的信息,后续我们需要什么信息,从中提取就行了。

结语

以上是幽络源的Yolov11从源码下载到进行识别测试的教程,如有不懂之处或感兴趣,可加QQ群307531422询问交流。

暂无评论内容