概述

Mimicmotion是腾讯推出的一个可控视频生成框架,能够根据单张图像和动作视频生成高质量的视频,我们只需要放入一张图片、一个视频,即可让图片中的人物随视频一样动起来。本文将通过ComfyUI与Mimicmotion进行整合,实现此功能,文中会详细讲解用到的插件和模型,需要下载的伙伴可在幽络源的基础文章概述中进行下载自取=>ComfyUI的下载与AI绘图使用 | 一篇文章即可学会

步骤1:下载与了解相关插件与模型

1.1下载安装ComfyUI_essentials插件到ComfyUI\custom_nodes

ComfyUI Essentials 是一个开源项目,旨在为 ComfyUI 提供额外的功能节点,以增强其图像处理能力。该项目由 cubiq 开发,包含了许多在 ComfyUI 核心中缺失的实用功能节点。通过安装 ComfyUI Essentials,用户可以扩展 ComfyUI 的功能,使其更加强大和灵活。

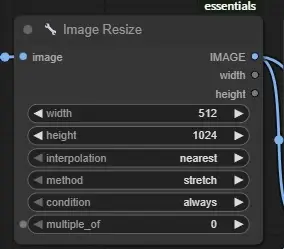

本文的工作流将用到其Image Resize节点,如图。

1.2下载安装ComfyUl-MimicMotionWrapper插件到ComfyUI\custom_nodes

ComfyUI-MimicMotionWrapper是专为ComfyUl设计的动作迁移插件,它基于先进的深度学习技术,能够精准捕捉源视频中的人体动作特征,并将其实时迁移到目标视频中。无论是舞蹈动作、运动姿态还是日常行为,都能通过简单操作实现风格化转换。

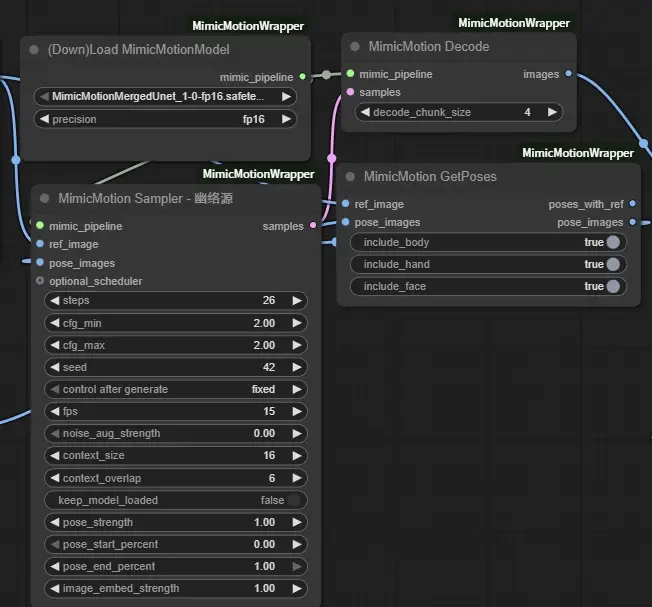

本文的工作流将用到其 MimicMotion Sampler、MimicMotion Decode、(Down)Load MimicMotionModel、MimicMotion GetPoses四个节点,如图。

1.3下载安装ComfyUI-VideoHelperSuite插件到ComfyUI\custom_nodes

ComfyUl-VideoHelperSuite是一个专为视频工作流设计的开源节点工具集合,提供了从加载到合并的一系列强大功能。这个项目不仅适合于专业开发者,也适用于希望简化视频操作流程的普通用户。该项目包含一系列I/O节点,如LoadVideo和Load ImageSequence,用于读取和处理视频及图像序列,以及videoCombine节点用于将图片合成输出视频。

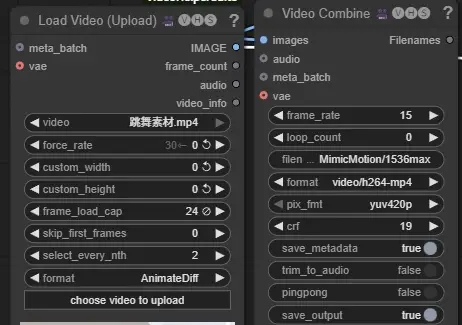

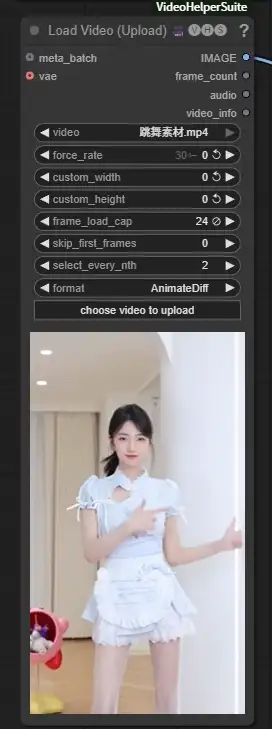

本文的工作流将会用其 Load Video (Upload)、Video Combine两个节点,这个插件无论是用什么方式生成视频,都是必不可少的,看过幽络源其他生成视频文章的一定是有这个插件的,如图。

1.4下载Mimicmotion模型到model中

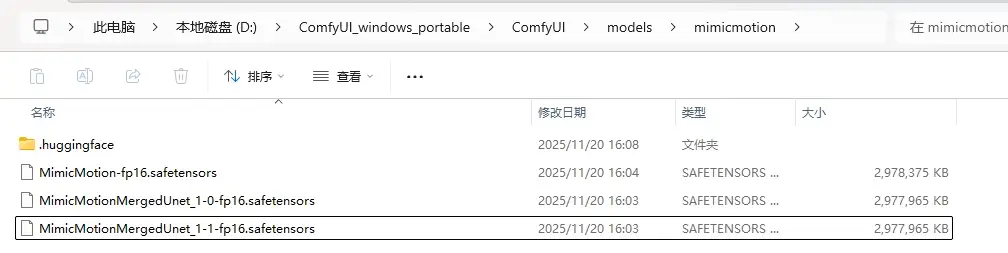

如图,这是我们使用Mimicmotion必须用到的模型,下图中的三个模型,我们都可以使用

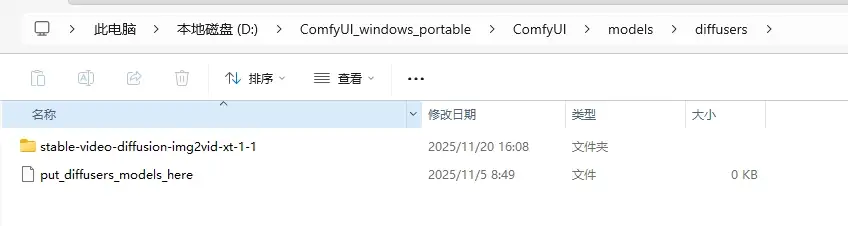

1.5下载stable-video-diffusion-img2vid-xt-1-1到ComfyUI\models\diffusers中

如图,将stable-video-diffusion-img2vid-xt-1-1下载后放入ComfyUI_windows_portable\ComfyUI\models\diffusers中

步骤2:开始创建工作流

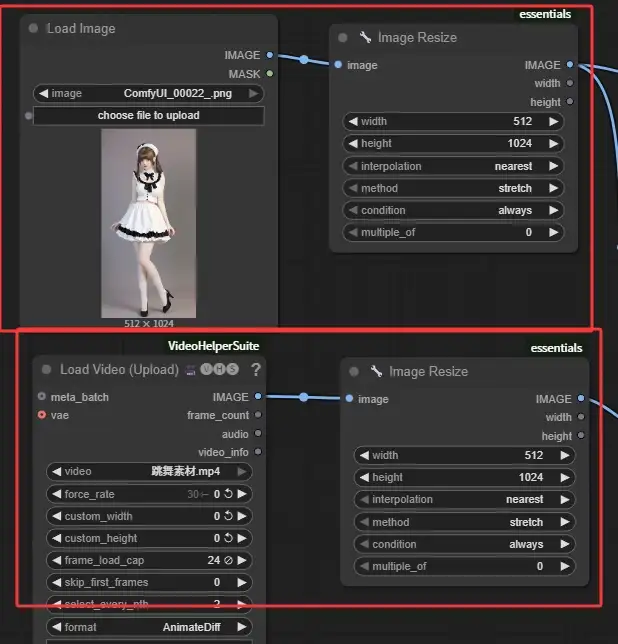

2.1创建加载一个人物图片和期望跳舞的视频的节点

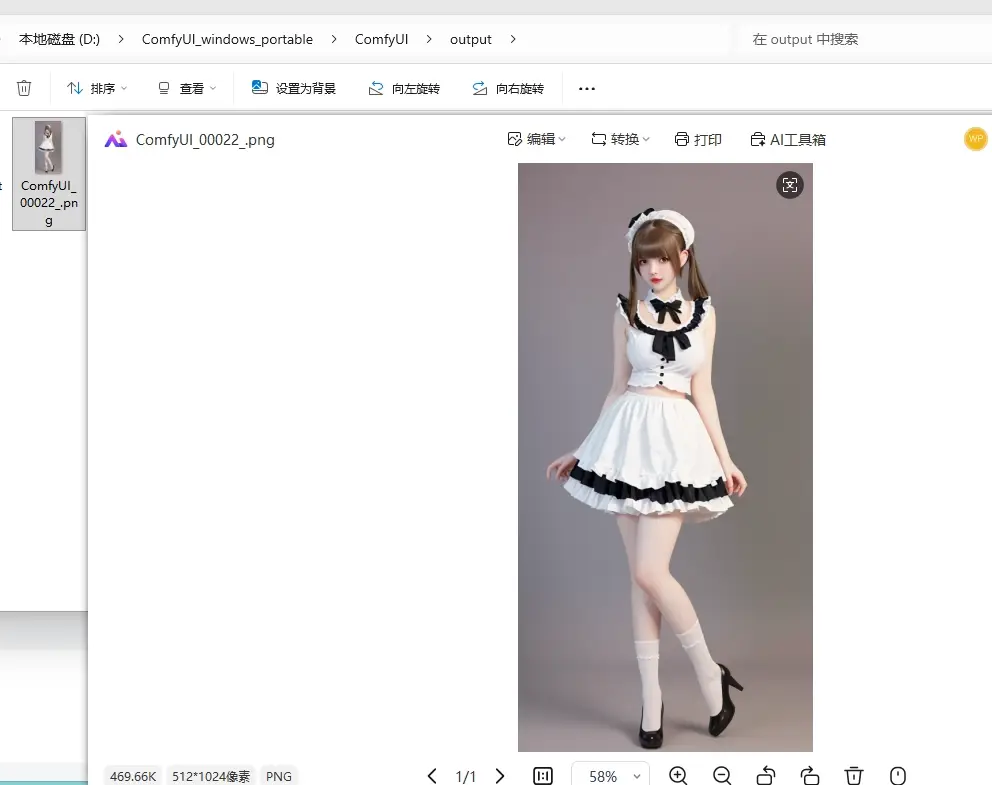

如果说视频是全身,那么建议人物的图片也是全身,幽络源这里通过概述中所提到的基础文章中的文生图自行生成了一张人物的全身图像,使用的是麦橘写实模型,注意背景最好是纯色,便于处理,如图

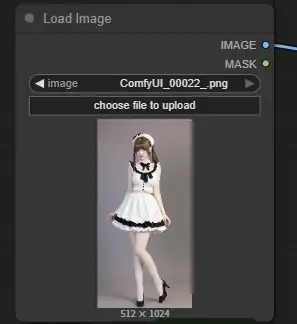

然后视频素材可以网上任意选择一段,视频的长度无所谓,节点中我们可以控制视频的使用长度,如下图,创建Load Image节点和VideoHelperSuite提供的Load Video节点,上传期望替换视频人物的图片,以及一段视频。

2.2创建两个重置图像尺寸的节点

如图,幽络源这里使用essentials插件提供的Image Resize节点,创建两个,然后将其分别连接到加载的图像和视频的IMAGE输出节点,调整Image Resize节点中的宽高,根据自己的需求调整即可,但注意保持一致

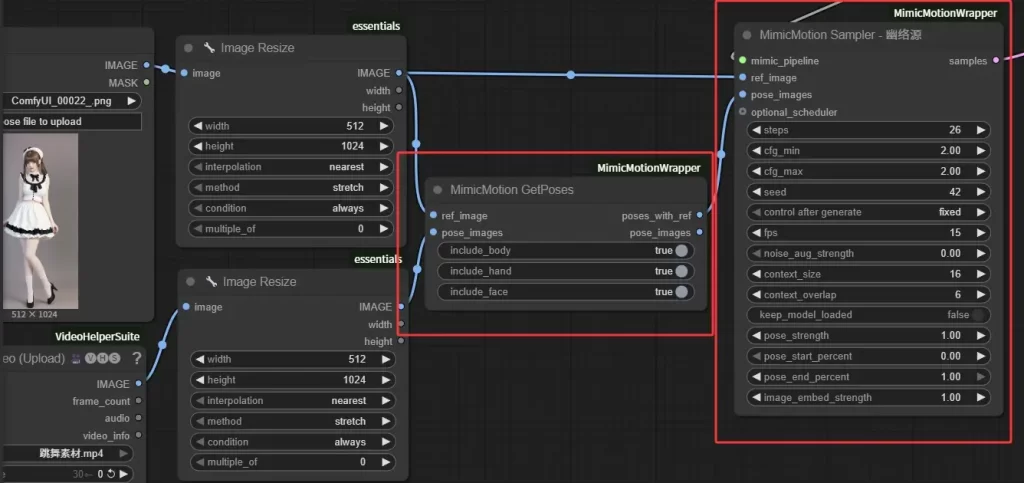

2.3创建获取姿势节点和采样器节点

如图,创建由MimicMotionWrapper提供的MimicMotion GetPoses和MimicMotion Sampler节点,将图片和视频的Image Resize节点输出分别按照如图进行连接

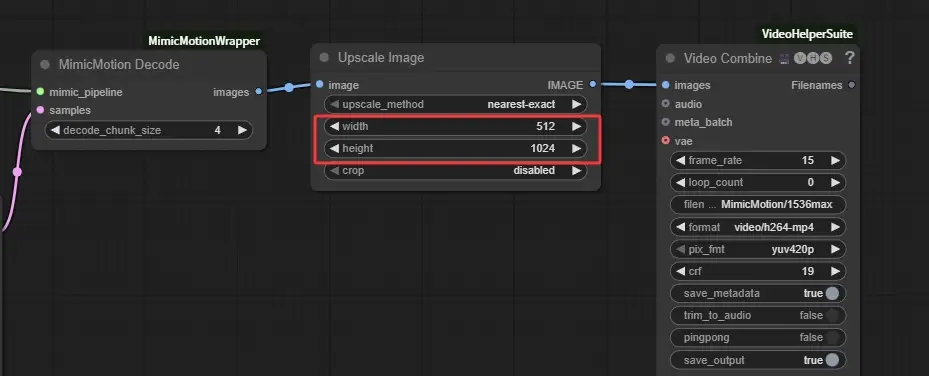

2.4创建模型节点和解码节点

如图,创建由MimicMotionWrapper提供的(Down)Load MimicMotionModel和MimicMotion Decode节点,将他们按照下图与采样器进行相连接,模型的加载使用Mimicmotion模型任意一个都可以,幽络源这里使用的是MimicMotionMergedUnet_1-0-fp16.safetensors。

2.5最终提升图像分辨率与保存视频

创建Upscale Image节点和Video Combine节点,分别用于图像分辨率提升以及保存视频,连接方式如下图,

注意这里的Upscale Image节点中的宽度高度要和我们对图片以及视频应用的ImageResize节点设置的保持一致。

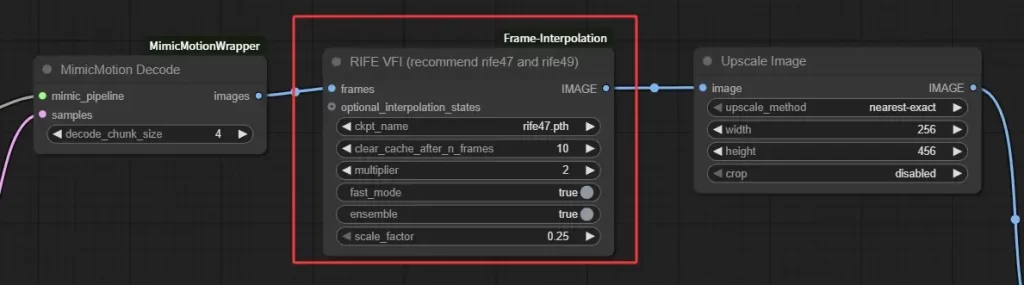

2.6额外的补帧节点

这个节点目幽络源这里测试目前看可以不需要,如果你需要的话也可以用上,它来自于ComfyUI-Frame-Interpolation插件提供的RIFE VFI节点,如图要使用的话只需插入到MimicMotion Decode和Upscale Image节点之间即可

步骤3:开始生成视频

幽络源这里建议,在完成工作流后,不要直接开始生成视频,特别是第一次,建议检查节点中,各个宽高是否设置的合理。

然后如果说你期望先生成一个1秒的视频来看下效果,那可以在Load Video节点中将frame_load_cap固定设置为24左右,因为24帧对人眼来说,一秒内完成24帧便是流畅的。

最后点击运行按钮,可以看到结果如下图,效果非常好

结语

如上为幽络源的“ComfyUI整合MimicMotion教程:单图+视频生成动态人物视频(附插件与模型下载)”教程,如有疑问或感兴趣可加入我们的官方QQ群307531422交流学习询问。